Tabla ANOVA con SPSS

El ANOVA o Análisis de Varianza (siglas de Analysis of Variance), es una técnica de análisis estadístico que se

utiliza para comparar las medias de más de 2 grupos, niveles o tratamientos, aunque su denominación hace referencia al estudio de la variabilidad observada, es decir, se comparan 3 o más medias a partir de la dispersión de esas medias, entre los grupos y dentro de los propios grupos. Con el ANOVA se trata de discernir qué variabilidad corresponde al factor en estudio, y cual al error o residuo experimental.

¿Qué es lo que significa hacer un ANOVA?. Se comparan primero las diferencias de medias intra-grupos (dentro de los 3 o más grupos que conforma la variable explicativa), para luego comprobar si las diferencias dentro del grupo son mayores o menores a las que hay entre grupos. Si las diferencia intra-grupos (dentro) son mayores que las diferencias inter-grupos (entre las muestras), significa que no hay diferencias entre los distintos grupos. El estadístico que genera el ANOVA es una F de Fisher-Snedecor, se trata de determinar la significatividad estadística con un p-valor asociado a dicho estadístico menor de 0,05, lo que arrojaría diferencias entre al menos un par de grupos.

Un ejemplo recurrente de Tabla ANOVA en Bioestadística, sería el corroborar no sólo en la existencia de diferencias entre los grupos como consecuencia de la administración o no de un determinado fármaco, sino que además puede interesar averiguar si existe un efecto distinto en términos, por ejemplo, de 2 cantidades diferentes del tratamiento proporcionado (comparar, por tanto, 3 o más muestras de una medición continua).

Al tratarse de mediciones numéricas de la variable de respuesta dependiente, frente a la independiente explicativa que conforma los más de 2 grupos, se procede desde un punto de vista paramétrico con un test como la Tabla ANOVA en el caso del cumplimiento de los supuestos de partida de normalidad y homogeneidad de varianzas (homocedasticidad), o desde un punto de vista no paramétrico como el de Kruskal-Wallis si no se cumplen alguno de dichos supuestos. En el caso de significatividad estadística, se procede a llevar a cabo la prueba de comparaciones múltiples o Post-Hoc, para detectar entre qué pares de grupos se producen tales diferencias en media. Siempre se trabaja con nivel de confianza del 95%, que se fija para la investigación. Los análisis estadísticos se llevan a cabo con el paquete estadístico SPSS, en su versión 25 o 26.

Índice del Artículo

Depuración de datos (outliers). Gráfico de Caja o Box-Plot.

En primer lugar se plantea la propia depuración de la base de datos, deshechando los valores atípicos, que pudieran dar lugar a equívocos en los resultados de los test y análisis estadísticos.

Se eliminan los casos/registros, marcados con un cículo pequeño y el número de caso, fuera del bigote superior o del inferior del Diagrama Box-Plot (o Gráfico de Caja y Bigotes), pues el conservarlos nos lleva a desvirtuar nuestros análisis y resultados estadísticos. La depuración de la base de datos (se puede hacer en una hoja de Excel y luego importar fácilmente desde SPSS) es un proceso de la misma importancia o más que el realizar los contrastes e interpretaciones correctamente.

Comprobación de las hipótesis previas

Normalidad.

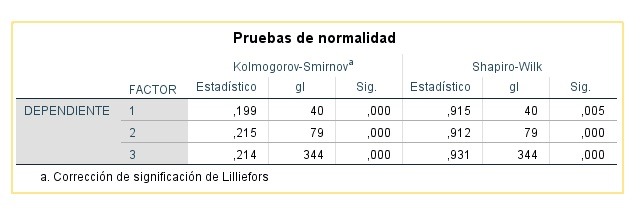

Se comprueba con los contrastes Kolmogorov-Smirnov-Lillefors, Shapiro-Wilk, y los test de Asimetría (próximo a 0 implica normalidad) y de Kurtosis (cercano a 3). La violación del supuesto de normalidad no afecta de forma importante al estadístico F de Fisher-Snedecor, siempre que los tamaños muestrales sean grandes (n>30 0 n>50, según el investigador/a), porque al tratarse de un test de comparativa de medias, se puede aplicar el Teorema Central del Límite.

Homocedasticidad

Comprobación: Análisis gráfico de residuos, Test de Esfericidad de Bartlett, Test de Hartley y el Test de Levene de homogeneidad de varianzas. El ANOVA es robusto frente a la violación de la hipótesis de homocedasticidad, si los tamaños muestrales de los grupos o tratamientos son idénticos o, al menos, muy parecidos.

Independencia y aleatoriedad de las muestras

Comprobación: Análisis gráfico de los residuos. El Test ANOVA no resulta robusto frente a la violación de la hipótesis de independencia y aleatoriedad de las muestras.

Supuesto de Normalidad

Si el tamaño muestral es lo suficientemente grande, se considera factible el que no se cumpla este supuesto de Normalidad, y proceder desde un punta de vista paramétrico, al realizar el test de comparativa de medias que proporciona la Tabla ANOVA con SPSS. El Test resulta estadísticamente significativo–esto es, se rechaza la normalidad–, si la probabilidad asociada a los contrastes de normalidad de Shapiro-Wilk (muestras menores de 30 o 50), o el p-valor de Kolmogorov- Smirnov-Lilliefors (n>30 ó 50), son menores de 0,05. Desde un punto de vista teórico, sólo en el caso de violarse gravemente el supuesto de normalidad con un tamaño muestral menor de 30 o 50, o al tratarse de una variable dependiente de tipo ordinal, se procede a realizar el equivalente no paramétrico, como es el test de Kruskal-Wallis.

Supuesto de Homocedasticidad

Contraste de Homocedasticidad o Test de homogeneidad de varianzas

Ho: Θ12 = Θ12 =…= Θn2

H1: Θi2 <> Θj2 (algún par de varianzas son distintas)

TEST DE COCHRAN: Sensible a discrepancias en Normalidad, mismo tamaño muestral.

TEST DE BARTLETT (ESFERICIDAD): Sensible a discrepancias en Normalidad, tamaños de muestras iguales., tamaño de muestra igual o distinto.

PRUEBA DE LEVENE: Menos sensible a discrepancias en Normalidad que el Test de Bartlett, tamaños de muestras iguales o distintos.

No se puede rechazar la hipótesis previa de Homocedasticidad, si el p-valor asociado al estadístico de Levene es mayor que 0,05, luego se corrobora la hipótesis de homogeneidad de varianzas de la variable dependiente (de respuesta), en los grupos que conforma la variable independiente (explicativa) en estudio.

Si la prueba de Levene muestra que las varianzas no son significativamente homogéneas (esto es, el contraste resulta estadísticamente significativo), se calcula de nuevo el estadístico F, seleccionando la casilla de opciones de Brown‐Forsythe o de Welch, con las que se lleva a cabo una transformación de las puntuaciones:

Tabla ANOVA

En el análisis de la descomposición de 2 variabilidades se fundamenta el Análisis de Varianza. En el

modelo más simple de un sólo factor, se trata de descomponer dicha variabilidad total en:

- La varianza atribuible a los distintos niveles del factor en estudio, esto es varianza inter-grupos.

- La varianza que se debe al error o residuo, o también, varianza intra-grupos.

Si la varianza intergrupos (debida al factor manipulado) es significativamente mayor que la varianza intragrupos (debida al error), se admite que hay diferencias entre los tratamientos, o lo que es lo mismo, que los distintos niveles del factor objeto de estudio, han influido de forma significativamente distinta sobre la variable dependiente de respuesta Y.

Ho (Hipótesis nula): Las medias de los 3 tratamientos son iguales

Ha (Alternativa): No todas las medias son iguales

Se proceder a realizar la Tabla ANOVA de comparativa de medias de la variable dependiente continua en los 3 grupos que conforma la variable independiente o factor (tratamientos), y en el caso de rechazo, se llevan a cabo las correspondientes pruebas POST HOC de Bonferroni (Test más conservador), de comparación de medias de las variables dependientes numéricas en estudio, en los 3 o más niveles del Factor o variable explicativa. En el caso de problemas con el supuesto de homocedasticidad del apartado anterior, se puede activar la casilla de verificación de la prueba de Welch, la más conveniente en este tipo de situaciones, y que arroja un p-valor para comprobar la significatividad estadística (p<0,05), parecido al de la Tabla ANOVA.

Por lo general, habrá influencia de la variable independiente o factor (la que conforma los 3 o más grupos), en la variable dependiente continua, si la variabilidad entregrupo o intergrupo (entre las medias de los grupos), es mayor que la intragrupo (dentro de los grupos) o error.

Si el Sig. o p-valor del Test es estadísticamente significativo (menor que 0,05), se rechaza la hipótesis nula de que los 3 o más grupos de comportan de la misma manera respecto a la media poblacional, es decir, al menos un par de medias difieren:

Pruebas POST-HOC o de comparaciones múltiples

El objetivo de las comparaciones múltiples de pares de medias es, además de comprobar que pares de medias presentan diferencias estadísticamente significativas, como parte del propio Análisis de Varianza, reducir la cantidad de error Tipo I o alfa, que se comete si comparamos 2 a 2 todas las muestras.

Del latín ‘después de esto‘, la interpretación del panel de resultados de salidas de SPSS viene a ser algo como que, el cruce de 2 tratamientos cualesquiera del factor cuyo p-valor sea menor que 0,05 se consideran estadísticamente significativas las diferencias. Si el valor de dicha diferencia de media es positivo, el valor mayor será el del tratamiento a la izquierda en la comparativa, lo cual se puede también corroborar con un análisis descriptivo de las medias, con el comando de submenú ‘EXPLORAR‘. Estas pruebas son más robustas que realizar una T de Student de comparación de todas las medias 2 a 2, pues disminuyen el error que se comete al estimar.

Tipos de Pruebas POST-HOC

La pruebas de comparaciones múltiples se suelen basar en la probabilidad de al menos un error de Tipo I en un conjunto de comparaciones. Se pueden considerar una especie de versión mejorada de la T de Student, de comparativas de 2 medias poblacionales. Las pruebas Post Hoc más comunes son:

Bonferroni

Esta corrección Post-Hoc de comparación múltiple se usa cuando se realizan muchas pruebas estadísticas al mismo tiempo. El problema con la ejecución de muchas pruebas simultáneas es que la probabilidad de un resultado significativo aumenta con cada prueba, por razones como que las probabilidades de error de Tipo II son altas para cada prueba o que corrige en exceso los errores de Tipo I. Se trata de la prueba que se suele considerar más conservadora, muy utilizada en Bioestadística y Psicometría.

Método de Scheffé

Se utiliza este test cuando se desea ver comparaciones Post Hoc de manera general, (en lugar de comparaciones por pares). Se tiene en cuenta este método habitualmente con tamaños de muestra desiguales. Muy corriente su utilización en pruebas Post Hoc asumiendo homocedasticidad, y en contrastes no paramétricos (HSD). Esta prueba permite no sólo comparar las medias de los niveles del Análisis de Varianza 2 a 2, sino también realizar comparaciones complejas, esto es, permite comparar la media de un nivel con un conjunto de medias de otros niveles. También permite comparar un conjunto de medias de distintos niveles con otro conjunto de medias de otros niveles. Este test fija la tasa de error de tipo I, en el α fijado para la investigación, normalmente del 5%.

Dunnett

Compara cada media con una media de control (experimental versus control).

Tukey

Está basado en un número que representa la distancia (diferencia significativa) entre grupos, para comparar de esta manera, cada media con cada otra media de los tratamientos del factor. Se trata de uno de los contrastes a posteriori más utilizados asumiendo homogeneidad de varianzas, prueba versátil que controla para el error de tipo I y es de naturaleza conservadora.

Sidak

Más utilizado en el ANOVA de medidas repetidas.

Prueba T2 de Tamhene y Prueba T3 de Dunnett

Los contrastes a posteriori más utilizados cuando no se parte de varianzas iguales, aunque en ambos casos, requieren del cumplimiento de la hipótesis previa de normalidad.

Procedimiento Games-Howell

Uso justificado en que las varianzas de la población se consideran diferentes (test más conveniente ante la violación del supuesto de homocedasticidad).

GT2 de Hochberg

Se suele usar cuando los tamaños de las muestras son diferentes.

Se puede tener en cuenta solo una comparación múltiple planificada, cuando el investigador no está interesado en realizar un ANOVA para testear todas las diferencias entre pares de medias, sino solo en algunas comparaciones entre los niveles del factor, no en todas las posibles, y se sabe de antemano qué comparativa medias en concreto, son susceptibles de contrastar.

*El test de Tukey, al igual que el ANOVA de Fisher, se basa en el supuesto de homogeneidad de varianzas. Cuando no se cumple este supuesto, es preferible realizar el ANOVA a través de la prueba de Welch y, si se rechaza la hipótesis nula, llevar a cabo las pruebas de comparaciones múltiples Post-Hoc mediante el test de Games-Howell.